近期,科技界圍繞蘋果公司一篇關(guān)于人工智能的論文展開了激烈討論。這篇題為《思維的錯(cuò)覺》的論文,由蘋果公司于6月6日發(fā)布,迅速引起了專家們的關(guān)注與爭議。

論文中,蘋果公司提出一個(gè)核心觀點(diǎn):即便是目前最頂尖的大型推理模型(LRMs),在面對復(fù)雜任務(wù)時(shí)也會遭遇崩潰。然而,這一結(jié)論隨即遭到了Open Philanthropy研究員Alex Lawsen的有力反駁。Lawsen認(rèn)為,蘋果的結(jié)論更多地反映了實(shí)驗(yàn)設(shè)計(jì)的瑕疵,而非模型推理能力的固有缺陷。

爭議的核心聚焦于蘋果論文中的一個(gè)具體案例:即便是最先進(jìn)的大型推理模型,在處理如漢諾塔問題這樣的復(fù)雜遞歸算法任務(wù)時(shí),也會徹底失敗。漢諾塔問題是一個(gè)經(jīng)典問題,要求將一系列大小不同的圓盤從一個(gè)柱子移動到另一個(gè)柱子,且需遵循特定規(guī)則。

針對這一觀點(diǎn),Alex Lawsen撰寫了一篇題為《思維錯(cuò)覺的錯(cuò)覺》的反駁文章。他指出,蘋果的研究混淆了輸出限制和評估設(shè)置的問題,從而得出了誤導(dǎo)性的結(jié)論。Lawsen詳細(xì)列舉了三大問題來挑戰(zhàn)蘋果的結(jié)論。

首先,Lawsen強(qiáng)調(diào)蘋果忽略了模型的Token預(yù)算限制。在處理超過8個(gè)圓盤的漢諾塔問題時(shí),一些模型如Anthropic的Claude Opus,已接近其輸出極限,甚至因節(jié)省Token而停止輸出。其次,蘋果的過河測試中包含了一些無解謎題,模型因拒絕解答而被判定為失敗,這顯然是不公平的。最后,蘋果的自動化評估腳本過于僵化,僅將完整步驟列表視為成功標(biāo)準(zhǔn),未能區(qū)分推理失敗與輸出截?cái)啵瑢?dǎo)致部分策略性輸出被誤判。

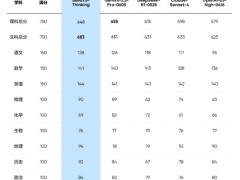

為了證明自己的觀點(diǎn),Lawsen重新設(shè)計(jì)了漢諾塔測試,要求模型生成遞歸Lua函數(shù)來打印解法,而非逐一列出步驟。結(jié)果令人震驚:Claude、Gemini和OpenAI的o3模型均能正確生成15個(gè)圓盤問題的算法解法,遠(yuǎn)超蘋果報(bào)告中“零成功”的復(fù)雜性界限。

Lawsen還指出,在去除人為輸出限制后,LRMs展現(xiàn)出了處理高復(fù)雜任務(wù)的推理能力,至少在算法生成層面是如此。這表明,問題可能并不在于模型本身,而在于評估方式。這一發(fā)現(xiàn)無疑為人工智能領(lǐng)域帶來了新的思考和啟示。

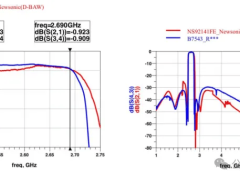

為了更直觀地展示其觀點(diǎn),Lawsen還提供了其他測試結(jié)果的對比圖,進(jìn)一步證明了其論點(diǎn)的合理性。

此次爭議不僅揭示了人工智能研究中的復(fù)雜性和挑戰(zhàn),也再次強(qiáng)調(diào)了科學(xué)評估方法的重要性。隨著人工智能技術(shù)的不斷發(fā)展,如何更準(zhǔn)確地評估模型的推理能力,將成為未來研究的重要方向。