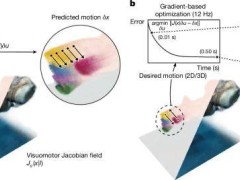

近期,麻省理工學(xué)院(MIT)的一支科研團(tuán)隊(duì)帶來了機(jī)器人技術(shù)領(lǐng)域的重大進(jìn)展。他們開發(fā)出一種創(chuàng)新的深度學(xué)習(xí)策略,使得軟體機(jī)器人和仿生機(jī)器人僅通過單個(gè)攝像頭便能學(xué)習(xí)并控制自身的運(yùn)動(dòng)。

這一突破性技術(shù)成果已于6月25日在《自然》雜志上正式發(fā)表,其有望大幅度削減機(jī)器人研發(fā)的成本。

傳統(tǒng)工業(yè)機(jī)器人雖然便于建模與控制,但其剛性的構(gòu)造在狹窄或復(fù)雜地形中顯得力不從心。軟體及仿生機(jī)器人盡管在環(huán)境適應(yīng)性上具有顯著優(yōu)勢(shì),卻常常需要依賴大量的傳感器以及定制化的空間模型。

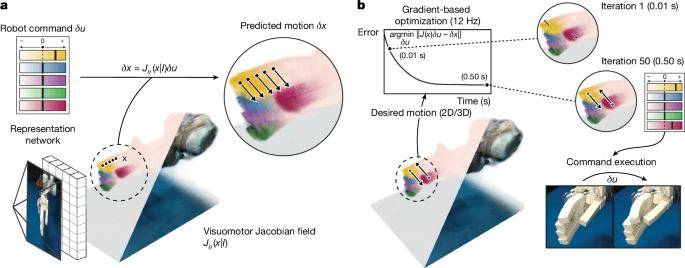

MIT的研究團(tuán)隊(duì)巧妙地運(yùn)用深度學(xué)習(xí)技術(shù),成功解決了這一難題。他們?cè)O(shè)計(jì)的新系統(tǒng)僅依靠單個(gè)攝像頭捕捉機(jī)器人的運(yùn)動(dòng)圖像,并結(jié)合“神經(jīng)雅可比場(chǎng)(NJF)”技術(shù),讓機(jī)器人能夠借助視覺反饋來建立對(duì)自身形態(tài)及運(yùn)動(dòng)能力的認(rèn)知。

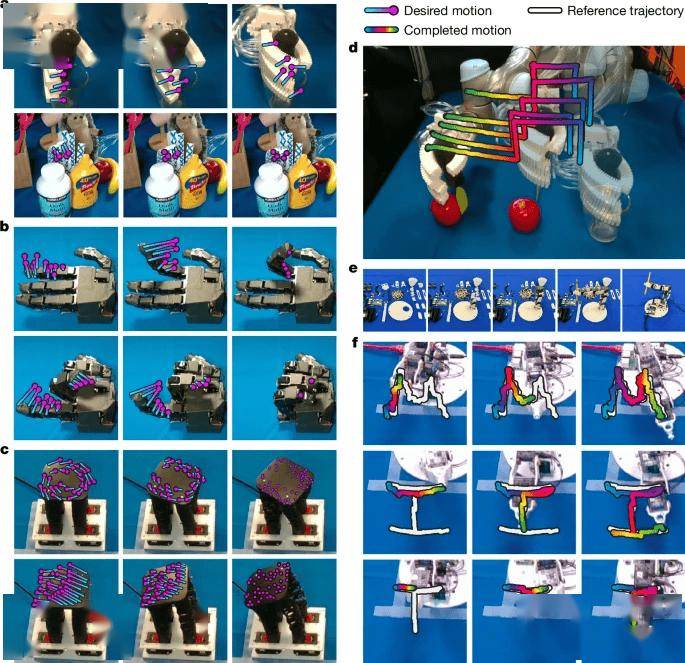

在實(shí)驗(yàn)中,研究團(tuán)隊(duì)對(duì)多種類型的機(jī)器人進(jìn)行了2至3小時(shí)的多視角隨機(jī)運(yùn)動(dòng)視頻訓(xùn)練。這一訓(xùn)練使得神經(jīng)網(wǎng)絡(luò)能夠通過單幀圖像重建出機(jī)器人的三維形態(tài)及運(yùn)動(dòng)范圍。

經(jīng)過測(cè)試,包括氣動(dòng)軟體機(jī)械手、奧利格羅機(jī)械手(擁有16個(gè)自由度)、3D打印機(jī)械臂以及低成本的Poppy機(jī)械臂在內(nèi)的多種機(jī)器人,均展現(xiàn)出了卓越的性能:關(guān)節(jié)運(yùn)動(dòng)誤差小于3度,指尖控制誤差小于4毫米,并且能夠適應(yīng)環(huán)境的動(dòng)態(tài)變化。

MIT的助理教授文森特·西茨曼(Vincent Sitzmann)指出:“視覺作為一種靈活的傳感器,為非結(jié)構(gòu)化環(huán)境(如農(nóng)場(chǎng)、工地等)中的機(jī)器人應(yīng)用開辟了新的可能性。”

CSAIL的主任丹妮拉·羅斯(Daniela Rus)補(bǔ)充道:“視覺反饋?zhàn)屜到y(tǒng)能夠建立起自身運(yùn)動(dòng)動(dòng)力學(xué)的內(nèi)部模型,從而在傳統(tǒng)定位方法失效的場(chǎng)景中實(shí)現(xiàn)自我監(jiān)督操作。”